INTRODUCCIÓN

Las variables cuantitativas son aquellas que han sido medidas en la

escala intervalar o de razón y pueden ser discretas o continuas. Por ejemplo el investigador le interesa

especialmente algunos datos que le ofrecen una información relevante para sus

conclusiones, por lo tanto, dará más importancia a los valores que tienen mayor o menor frecuencia.

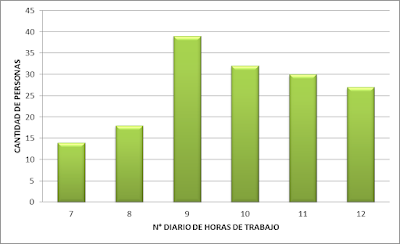

En los gráficos de arriba se analizan básicamente las frecuencias de los

valores de la variable,

MEDIDAS DE RESUMEN

En estadística también es necesario RESUMIR, lo cual quiere decir que debemos resaltar los aspectos más importante, dicho de otra forma, dejar en evidencia los elementos que representan más significativamente al estudio. En estadística lo que buscamos es resumir los conjuntos de datos.

Estos resúmenes se hacen a partir de MEDIDAS

DE RESUMEN estadísticos.

Tipos:

Tipos:

Medidas de tendencia central:

- media

- mediana

- moda

Medidas de tendencia no central:

- Percentil: se utilizan para variables de datos muy complejos como por ejemplo el rendimiento académico. Esta última medida es estudiada por el ranking de notas, para lo cual es dividido en tres partes iguales. A cada parte le denominamos un tercio (inferior, medio y superior) cada uno con 33 % de manera que cada tercio será estudiado de un modo especial.

- rango intercuartilico

Medidas de dispersión:

- varianza

- rango

- desviación estandar

- coeficiente de variación

Por la forma que tiene una variable, por forma se entiende en donde se concentran más los datos.

- Coeficiente de asimetria para variables unimodales

- coficiente de asimetria para variables no unimodales

La

estadística no solamente cuantifica a una variable, también destaca los aspectos más relevantes de esta.

MEDIDAS DE TENDENCIA CENTRAL

MEDIA ARITMÉTICA

Como es evidente para calcular el valor de la media aritmética intervienen todos los datos ( la media aritmética es el resultado de dividir la suma de todos los datos entre la cantidad de datos)

Como es evidente para calcular el valor de la media aritmética intervienen todos los datos ( la media aritmética es el resultado de dividir la suma de todos los datos entre la cantidad de datos)

La media aritmética es una medida estadística que tiene limitaciones. Basta que dentro del conjunto de valores existan datos que sean muy elevados o

muy bajos para que la media aritmética ya no resuma adecuadamente el conjunto de datos. Si en un conjunto de datos existen valores extremos muy marcados la

media aritmética se desvirtúa y resultará en un valor que no corresponde a la

media verdadera del conjunto de datos. Por lo tanto ya no es una medida de resumen adecuada. debido a esto la mayoría de pruebas estadísticas no se basan en la media sino en la mediana. Aquellas pruebas estadísticas basadas en la media se las denomina pruebas paramétricas.

En los trabajos de investigación debemos observar si existe

algún valor que sobrepase a los demás para considerar el valor de la media de

ese estudio.Si consideramos en la media de un grupo de datos un valor demasiado elevado la media se sobrevaloraría y si considerásemos un valor muy bajo la media se infravaloraría.

Una propiedad muy importante de la media aritmética es:

Ejemplo:

Se emplea cuando existen datos extremos en el conjunto de datos y por lo

tanto la media no representa un valor adecuado de medida para el conjunto de

datos. Para calcular la mediana primero debemos ordenar los datos de forma

creciente o decreciente. Nosotros adoptaremos el ordenamiento creciente. Cuando “n”(número de datos) es impar la mediana es el valor de la

variable que ocupa la posición central:

X: 4,2,2,8,14

2,2,4,8,14

Media = 4

Si el número de tatos es par entonces la mediana será el valor promedio

de los dos valores centrales:

Para calcular la mediana no utilizamos todos los datos,

solamente algunos valores según la cantidad de datos del conjunto. Por ello la

mediana no está afectada por valores extremos como es evidente.

Si la media y la mediana

coinciden entonces quiere decir que no existen valores extremos.

La media comprende valores numéricos reales, lo que puede ser la razón por la que se usa tan comúnmente. Unos pocos valores excepcionalmente grandes o pequeños pueden afectar significativamente la media. Por ejemplo, si un paciente que recibió material de contraste antes de la tomografía computarizada (TC) desarrolló una reacción grave y potencialmente mortal y tuvo que ser ingresado en la unidad de cuidados intensivos, el costo de la atención de ese paciente podría ser de varios cientos de miles de dólares. Esto haría que el costo promedio de la atención asociada con la TC mejorada con material de contraste fuera mucho más alto que el costo promedio, ya que sin un episodio de este tipo, los costos podrían ser de varios cientos de dólares. Por esta razón, puede ser más apropiado usar la mediana en lugar de la media para describir el centro de un conjunto de datos si los datos contienen algunos valores atípicos muy grandes o muy pequeños o si los datos no están centrados (Statistical concepts series- SeemaS. Sonnad, PhD).

MODA

La moda es el valor de la

variable que se repite más. Algo que ya vimos anteriormente cuando

estudiamos las frecuencias para cada valor posible de la variable. Por lo tanto

es el valor que tiene mayor frecuencia. En el gráfico de abajo observamos que

la moda está en la parte central, también vemos que existen conjuntos de datos donde la moda es doble aunque

pertenezcan a un solo conjunto de tatos (bimodal). También existe la multimodal

y la amodal.

Por ejemplo si en un grupo todos tienen la misma edad sería un conjunto

de datos unimodal. Cuando la variable no tiene diferencial y por lo tanto encontramos dos

grupos con datos que difieren y en consecuencia dos modas, evidentemente se

trata de un caso bimodal. Por ejemplo pesos de dos grupos distintos o edades.

También el caso del promedio ponderado. Calcular la media en este tipo de

variable no es viable por la diferencia en los datos. Por ello es preferible hacer uso del percentil. En el caso de una multimodal la dispersión es grande

y tampoco es recomendable estudiar los datos del grupo en base a la media sino

más bien por el percentil.

En el ámbito de la salud los percentiles son muy importantes por la

complejidad de los datos.

Con la experiencia veremos que medida de conjunto debemos tomar para cada variable.

Análisis de los indicadores:

Para el diagnóstico 1 y 2 vemos que la media y la mediana son muy parecidos eso quiere decir que no existen valores extremos para la variable y la media representa muy bien al conjunto de datos.

Para el diagnóstico 1 y 2 vemos que la media y la mediana son muy parecidos eso quiere decir que no existen valores extremos para la variable y la media representa muy bien al conjunto de datos.

Para el diagnostico 1 hay dos modas 1,5 1.6 Excel nos da la

menor moda evidentemente este es un grupo de datos bimodal. Con SPSS sí se

indica cuando es bimodal por lo que nos muestra las modas completas.

Observamos que en el diagnostico 2 se repite 1,4 tres veces(más del 50 %)

por lo cual se considera un grupo unimodal.

En el tercer caso también estamos frente a un grupo de datos bimodal ( 0.6

y 0.5)

Por lo que observamos la moda no es necesariamente única puede tener más de un

valor porque ella nos indica la frecuencia más alta de un valor para la

variable.

La mediana al ocupar la posición centran de los datos divide al conjunto de datos en dos mitades de 50 % cada una.

La mediana al ocupar la posición centran de los datos divide al conjunto de datos en dos mitades de 50 % cada una.

Concluiremos que la mejor medida es la media al no

existir datos extremos. Resume adecuadamente al conjunto de datos.

Vemos por el gráfico que la mediana queda dentro del 50% superior, por lo tanto el 50 %

inferior siempre será menor que el valor de la mediana. La media puede encontrarse a la derecha o a la

izquierda de la mediana si se trata del caso de un grupo de datos que tiene

datos extremos a la derecha o a la izquierda, es decir o muy altos o muy bajos.

Evidentemente esta situación ocurre en el caso de conjuntos de datos multimodales o bimodales. En el

ejemplo anterior solamente nos encontramos frente a un caso donde la mediana y la media

coinciden bastante.

MEDIDAS DE DISPERSIÓN

El cálculo de las medidas de dispersión nos da una idea de la proximidad

de los datos al valor de la media. Esto quiere decir que si los valores se encuentran muy alejados de la media estamos frente a un grupo

de datos muy disperso, por lo tanto es una

medida de estudio de los conjuntos de datos, en cuanto a la relación entre los datos. Mediante el análisis de la dispersión se puede determinar la variabilidad de la población o muestra. De esta forma, estudiamos una condición de la muestra y por ende de la población: la propiedad de presentar diferencias entre los datos. Es evidente que sin la variabilidad propia de las poblaciones no sería de ninguna utilidad la estadística como instrumento de análisis. Las medidas de dispersión también pueden ser tomadas en función de la

mediana.

Las medidas de dispersión también nos dan una idea clara acerca de la

existencia de datos extremos que se alejan mucho de la media. En este caso determinaríamos indirectamente la utilidad de la media.

RANGO

El rango es el conjunto de datos sobre el cual esta fluctuando la

variable. Por ejemplo si tenemos un grupo de datos, en el que los valores de los

datos van de 50 a 70 y otro grupo en el

que los valores de los datos van de 50 a 80 podemos decir que el rango de

variación del segundo grupo es más amplio, por lo tanto en el

segundo grupo hay más variabilidad. El rango es una

medida de dispersión porque con ella podemos medir que tanta variabilidad y

amplitud de los datos existen en un grupo de datos. Una desventaja del rango es que solamente toma los datos extremos pero

no dice nada de los datos intermedios. El rango se suele utilizar para grupos

de datos en donde no existe excesiva variabilidad.

VARIANZA

La varianza es una medida natural de dispersión. Es el promedio de la suma de los cuadrados de las desviaciones de los valores respecto a su media aritmética. Mide las dispersión de los datos respecto a su media aritmética.

La varianza es una medida natural de dispersión. Es el promedio de la suma de los cuadrados de las desviaciones de los valores respecto a su media aritmética. Mide las dispersión de los datos respecto a su media aritmética.

Si todos los datos se parecen a la media entonces la varianza tendrá un

valor evidentemente bajo. En este caso decimos que la variable no es muy

dispersa respecto a su media. En el caso contrario habría una dispersión alta.

La varianza es una

medida elevada al cuadrado lo cual dificulta un poco la comprensión del conjunto de

datos por ello se trabaja mejor con la desviación

estándar.

La varianza puede estar afectada por los valores extremos de

los datos porque toma en cuenta todos los datos y el número de datos como en el

caso de la media. También podemos decir que una media afectada por valores

extremos consecuentemente tendrá un alta varianza.

DESVIACIÓN ESTÁNDAR

La desviación estándar es la raíz cuadrada positiva de la varianza.

Tengamos presente que la varianza es una medida de resumen adecuada para comparar

grupos de datos con dispersión de una misma variable. La desviación estándar tiene todas las características de la varianza.

Calculemos el mínimo, el máximo, el rango, la varianza y la desviación

estándar con el ejemplo anterior (el de la creatinina en sangre)

*Observamos que VAR.P es la función estadística en el Excel para calcular

la varianza en el caso de que estemos trabajando con toda la población.

*Observamos también que la desviación estándar se calcula con la función en

Excel DESVEST.P en el caso de que estemos trabajando con la población.

Análisis de los indicadores estadísticos

En la tabla de arriba, al comparar las respectivas varianzas y desviaciones estándar entre los diferentes diagnósticos, que el primer y tercer diagnostico tienen baja varianza. Recordemos que la varianza resulta de una operación entre los valores de los datos y su media por lo cual nos dice poco aisladamente. Pero si comparamos estas medidas entonces si podemos encontrar ciertas relaciones (comparación del diagnostico 1 y 3). Los grupos de pacientes con el diagnóstico 1 y 3 respectivamente demuestran que el valor de sus varianzas son iguales es decir tienen la la misma medida de dispersión.

En el caso del segundo diagnostico vemos que los valores respecto a la

media se encuentran un poco más dispersos (mayor varianza). Entre el diagnostico uno y dos( medias de ambos

diagnósticos 1.52) la media es más adecuada. En el caso uno por tener menor

varianza. Por esto decimos que no debemos confiarnos en la coincidencia de

ciertas medidas como la media entre dos conjuntos de datos para tipificarlos

sino también observando la dispersión por medio de la varianza. A pesar de tener los pacientes del diagnóstico 1 y 2, para creatinina, la

misma media; para los pacientes con el diagnostico 1 la desviación estándar de la

creatinina es menor de la desviación estándar con el diagnostico 2. Por ello la

media de la creatinina para los pacientes del diagnóstico uno es una buena

medida de resumen, respecto a la media de los pacientes con diagnostico 2. Finalmente observamos que el grupo más disperso es el grupo 2 respecto a su media. y

también respecto a los otros grupos.

MEDIDAS DE POSICIÓN NO CENTRAL

Un resumen adecuado de un

conjunto de datos requiere tanto una medida del centro como una medida de la

variabilidad. Al igual que con el centro, hay varias opciones para medir la

variabilidad. Cada medida de variabilidad se asocia más a menudo con una de las

medidas del centro. Cuando se usa la mediana para describir el centro, la

variabilidad y la forma general de la distribución de datos se describen

mediante el uso de percentiles. El percentil x es el valor en el que el x por

ciento de los datos se encuentra por debajo de ese percentil y el resto por

encima de él; por lo tanto, la mediana es también el percentil 50. Los

percentiles 25 y 75, también conocidos como los cuartiles inferior y superior,

respectivamente, se usan a menudo para describir los datos (Statistical concepts series- SeemaS. Sonnad, PhD).

Percentil significa que estamos dividiendo a todo el conjunto de datos

en 100 partes iguales.Los percentiles se utilizan para medir variables complejas y muy dispersas donde la media no es muy adecuada y se usa para comparar un valor individual con una norma. En educación es muy util porque se suelen analizar los tercios, cuartiles y quintiles. Al investigador le interesa por otro lado no estudiar cada parte

independientemente (1%) sino por grupos de percentiles mayores, como estudiar el 15% inferior

de los datos. En este último caso al valor que divide el 15 %

inferior del 85 % superior se le llama percentil 15 (permiten establecer un punto de corte).

Al comparar un valor individual con una norma buscamos, por ejemplo, en el

caso de un postulante a un puesto académico que este pertenezca al

quinto superior, es decir el 20 % superior y le corresponde el percentil 80 (P80). Los percentiles se usan para estudiar las curvas endémicas y en mucha

cosas relacionadas con la salud. Cuando estamos hablando de percentiles estamos

hablando en términos relativos de comparación y no en términos absolutos. Por

ejemplo los promedios ponderados representan en términos absolutos el desempeño

del alumno en su centro de estudio mientras que el quinto superior representa

también el desempeño del alumno en su centro de educación pero en términos

relativos. Es importante aclarar que los percentiles dan una información más

fidedigna de la realidad cuando se trata de comparar puntajes.

Los cuartiles son aquellos que dividen el 100 % de los datos en cuatro

partes iguales(cada uno con el 25 %). El cuartil es un percentil muy

utilizado, al igual que el tercio y el quintil.50 los quintos cada parte tiene el 20 %. También existen los deciles.

Vemos en el gráfico de arriba que el cuartil 2 o percentil 50 coincide

con la mediana. Porque sabemos que la mediana divide a los datos en 50 y 50 %. La recomendación es que si estamos frente a variables complejas utilicemos

los percentiles más adecuados. Recordemos que la mediana se encuentra entre el cuartil uno y tres, es decir está en el 50 % central.

Variable: tiempo de espera, cuantitativa continua

recordemos en relación con el

cálculo, en Excel, que la matriz es resultado de las filas por columnas o de

todos los datos que tengamos a disposición.

Vemos que para la última pregunta del ejercicio anterior tuvimos que

calcular el percentil 30 y el 70, porque nos piden el 40 % central.

RANGO INTERCUARTILICO

El rango intercuartilico viene a ser la diferencia entre el cuartil 3 y el cuartil 1. Por lo tanto es el intervalo

que contiene el 50 % central de datos y se usa cuando se ha empleado la mediana como medida de

tendencia central (MTC).

Cuando los datos intercuartilicos, que se encuentran dentro del 50 %

central, es decir entre el cuartil 1 y el

cuartil 3 están muy alejados de la mediana se dice que hay

mucha dispersión, dicho de otra forma si el intervalo del 50 % central es muy amplio entonces los

datos se encuentran alejados de la mediana. Consideremos nuevamente al rango intercuartilico como un intervalo de

datos central dentro del conjunto de datos y también es una medida de este

último.

COEFICIENTE DE VARIACIÓN

El coeficiente de variación es una medida de la dispersión y por ello se le denomina medida de dispersión relativa. Recordemos que existen medidas de dispersión absolutas y relativas. En este punto estudiaremos una medida de dispersión relativa.

El rango, varianza,

desviación estándar y rango intercuartilico son medidas de dispersión absolutas

porque se expresan en términos de los valores de las variables y además sirven

para comparar grupos de valores de una misma variable. El coeficiente de

variación no se expresa en unidades de la variable. Por ello se llama medida de

dispersión relativa. Nos da un valor relativo el cual se multiplica por 100.

Sirve para comparar valores de variables distintas.

El coeficiente de variación es igual a la razón entre la desviación estándar y la media multiplicado por 100

Por ejemplo podríamos

pensar en la variable que tiene los datos más dispersos respecto a su media.

Como la edad comparada con la cantidad de hijos. Cuando el valor de la

media está muy cercano a cero no es muy recomendable utilizar el coeficiente de

variación porque tendríamos un valor indeterminado o cuando los valores de la

variables están expresados en valores negativos.

En el problema nos están

pidiendo saber cuál de las dos variables es la más dispersa respecto a su

propia media. Es decir estamos comparando la dispersión de dos variables

distintas (creatinina/nitrogeno ureico).

En la práctica con Excel para calcular una división se una “/” y para multiplicar “*”asterisco. En este caso del coeficiente de variación fue por 100.

Si una variable de tipo

cuantitativa tiene coeficiente de variación mayor del 10 % se dice que es

heterogénea respecto a su media.

MEDIDAS DE FORMA

Son medidas que permiten tener una idea de la

forma de la distribución de una variable cuantitativa, es frecuente que los

valores de una distribución tiendan a ser similares a ambos lados de las

medidas de posición. Pero en otros casos no se comporta de esta forma.

"Sesgo" es otro término usado para esta medida. Si bien existe una fórmula para calcular el sesgo, que se refiere

al grado en que una distribución es asimétrica, no se usa comúnmente en el

análisis de datos. Los datos que están sesgados hacia la derecha son comunes en los estudios biológicos porque

muchas mediciones involucran variables que tienen un límite inferior natural

pero no un límite superior definitivo. Por ejemplo, la duración de la estadía

en el hospital no puede ser inferior a 1 día o 1 hora (según las unidades

utilizadas por un hospital determinado), pero puede durar hasta varios cientos

de días. Esto último daría lugar a una distribución con más valores por debajo

de algunos límites y luego algunos valores atípicos que crean una larga

"cola" a la derecha (Statistical concepts series- SeemaS. Sonnad, PhD).

COEFICIENTE DE ASIMETRIA

Llamado también sesgo

de Pearson modificado para una variable unimodal es :

Como vemos en la

fórmula de arriba interviene la media y la mediana. La media sabemos está

influenciada por los valores extremos en cambio la mediana no.

Cuando no existen datos

extremos en el conjunto de datos de la variable entonces la media y la mediana

son las mismas y por lo tanto la diferencia entre estas es cero entonces el

coeficiente de asimetría también es cero.

En este caso hablamos de una curva o distribución simétrica. También

decimos que media, mediana y moda están coincidiendo en el mismo punto ocupando

la posición central:

Un caso típico de esta forma de distribución es el coeficiente de inteligencia. Esta variable se distribuye simétricamente alrededor de una media formando una campana.

ASIMETRÍA POSITIVA

Cuando la media es

mayor que la mediana entonces es evidente que el coeficiente de asimetría tiene

un valor positivo o mayor que cero (distribución con asimetría positiva). En

este caso sabemos que para valores más altos de la variable las frecuencias son

más bajas. Los datos se concentran en valores más bajos. Por ello la moda toma

valores más bajos. Se le denomina “cola a la derecha”

Para este caso podríamos pensar en el ingreso economico mensual de los hogares del Perú. Esta variable se distribuye de manera asimétrica alrededor de su media. Existirán mucha más frecuencia de valores bajos de la variable que de valores altos.

ASIMETRÍA NEGATIVA

Cuando la media es

menor que la mediana nos encontraríamos ante un valor negativo del coeficiente

de asimetría. Decimos que es una distribución con asimetría negativa. Es todo

lo contrario al caso anterior. Sabemos que en este caso existen datos que se

concentran para valores más altos o que para valores más altos de la variable

las frecuencias son más altas. Se le denomina “cola a la izquierda”.

Si pensamos en una población de adultos sedentarios es muy probable que encontremos valores de peso mas altos. Cuando se presentan valores de la variable altos con mucha más frecuencia que los valores bajos entonces la curva de distribución es asimétrica con cola hacia la izquierda.

Por lo visto el coeficiente de asimetría en positiva, negativa o simétrica nos sirve para tipificar a una variable.

Por lo visto el coeficiente de asimetría en positiva, negativa o simétrica nos sirve para tipificar a una variable.

COEFICIENTE DE ASIMETRIA

PARA VARIABLES NO UNIMODALES

Existe un gráfico muy

útil que pertenece al ANALISIS EXPLORATORIO DE DATOS. Previamente al análisis

estadístico debemos hacer un estudio de la naturaleza de los datos. Es

necesario que los datos sean de tipo cuantitativo. El GRAFICO O DIAGRAMA DE CAJAS Y BIGOTES es una herramienta muy útil para estos casos.

El gráfico que mostramos abajo es totalmente independiente de que la variable sea unimodal, Bimodal o multimodal.

En el eje vertical se

encuentran los diferentes valores para la variable, en el nivel superior se

encontrarían los valores más altos. El gráfico de cajas y bigotes está basado en los percentiles. El 50 % central representa el rango intercuartilico y que este a su

vez es dividido por la mediana en dos partes cada una con el 25 %. Esto

solamente sucede como lo indica el gráfico con variables simétricas. La caja

representa siempre al 50 % central(

rango intercuartilico). Y la línea horizontal representa siempre a la mediana.

Los espacios sobre la media y debajo de

ella dentro de la caja siempre representan también el 25 y 25 %. La altura de la caja representa la

dispersión de los datos.

OTRAS FORMAS DISTINTAS A LA ASIMETRIA

En la figura de abajo el

primer gráfico, a la izquierda, observamos que el 25 % superior en la caja es

mucho más compacto, es decir los datos se encuentran menos dispersos en esta

parte de la caja y más cerca de la mediana. Observamos que la mediana se acerca más al cuartil 3. Los

valores se concentran más sobre la

mediana, esto quiere decir que los

valores fluctúan en un nivel superior de valores, en otras palabras existen más

valores altos que bajos. Por todo esto podemos indicar que la variable tendrá

una asimetría negativa. EN ESTE CASO RECOMENDAMOS LA MEDIANA COMO como medida

de resumen

En el segundo gráfico a

partir de la izquierda vemos que el 25 % inferior a la mediana es mucho más

compacto lo cual quiere decir que los valores de la variable se concentran en

niveles bajos de valor. Por ello podemos decir, a dieferencia del caso

anterior, que la variable presenta asimetría positiva. No olvidemos que la

mediana se aproxima al cuartil 1. EN ESTE CASO RECOMENDAMOS LA MEDIANA. como

medida de resumen

En el tercer gráfico a

partir de la izquierda observamos que el cuartil 3 coincide con el máximo valor

de la variable. Vemos que se trata de una variable muy dispersa. EN ESTE

GRAFICO RECOMENDAMOS LA MEDIANA. como medida de resumen

En el cuarto gráfico vemos

que los valores para el cuartil 1,2 y 3 no se diferencian mucho por lo tanto

estamos hablando de una variable poco dispersa y muy homogénea donde los

valores se encuentran cerca de la medina y del promedio. EN ESTE CASO

RECOMENDAMOS LA MEDIA, como medida de resumen.

En el quinto gráfico vemos

que coincide la mediana con el cuartil 3 por lo que podemos decir que es una

variable muy homogénea. RECOMENDAMOS USAR LA MEDIA.como medida de resumen.

En el sexto gráfico

observamos algunos datos fuera del gráfico. No son valores de la variable, nos

indican algunos datos extremos. Los que se encuentran con un circulo pequeño

nos indican valores todavía cercanos mientras que los que se encuentran al lado

de un asterisco nos indican valores remotos muy alejados de los limites.

RECOMENDAMOS LA MEDIANA. como medida de resumen

CONCLUSIONES

Es necesario hacer una

serie de estudios y análisis con los datos de la variable para determinar la

mejor forma de representar los datos.

-análisis de tendencia

central (mediana)

-análisis de dispersión a

través del rango intercuartilico

-Análisis de forma ( lo

que queremos saber es si la mediana está cerca del cuartil 3 o del cuartil 1.

Si deseamos hacer un

análisis estadístico donde la media es necesaria entonces primero debemos hacer

un estudio exploratorio de la variable, una especie de radiografía a los datos

para saber qué tipo de análisis es el más adecuado.

El beneficio más importante de utilizar el diagrama de cajas es que podemos determinar la existencia de datos extremos o atípicos.

El beneficio más importante de utilizar el diagrama de cajas es que podemos determinar la existencia de datos extremos o atípicos.

NOTA

-Debemos apuntar que esta teoría fue creada por el estadístico John Tucker. En el año 1977.

-El primer nivel de

investigación es el exploratorio. Se hace cuando no se tiene mucho conocimiento

de las variables que estamos estudiando.

-Este tipo de gráficos

de cajas se utiliza mucho en los estudios e informes de varias

instituciones.

-Otro método gráfico para

representar la distribución se conoce como el diagrama de tallo y hoja, que es

útil para conjuntos de datos relativamente pequeños, como se observa en muchas

investigaciones radiológicas. Con este enfoque, se conserva más información de

los datos originales de la que se conserva con el histograma o el polígono de

frecuencia, pero aún se proporciona un resumen gráfico. Para hacer un diagrama

de tallo, los primeros dígitos de los valores de los datos representan los

tallos. Los tallos aparecen verticalmente con una línea vertical a su derecha,

y los dígitos se ordenan en orden ascendente. Luego, el segundo dígito de cada

valor aparece como una hoja a la derecha del tallo adecuado

Muchas gracias Delia tarde

ResponderEliminarBay